Tras el pinchazo de la inteligencia artificial: qué es, que no es y para que puede servirnos

¿Qué es, de verdad, y para que sirve la IA generativa? ¿Qué podemos esperar que pase con esta tecnología una vez que se pase del todo el hype? ¿Transformará nuestras vidas? ¿Reemplazará a los humanos?

An English version of this article is available here.

Ocurre con eso que hemos llamado “inteligencia artificial” lo mismo que pasó con otras tecnologías —como el Metaverso de Facebook o las Google Glasses—: nacieron de la mano de unas empresas que tenían mucho interés en que creyéramos que iban a ser revolucionarias.

Hasta hace un par de meses, varias de compañías más grandes del mundo seguían prometiendo que iban a crear una “inteligencia artificial general”: un ser pensante que sería “superior” a los humanos y capaz de sustituirnos en todo. Anunciaban, en otras palabras, el nacimiento de una nueva especie de máquinas todopoderosas que reemplazaría a las personas.

La cosa llegó a tal disparate que en una conferencia organizada por Google a la que asistí hace unos meses, uno de los ponentes afirmaba, sin despeinarse, que tendríamos que instalarnos un chip en el cerebro para estar a la altura de los robots que estaban por venir. Cundía el pánico corporate y nadie estaba a salvo.

Algunas personas hemos defendido durante mucho tiempo que eso no iba a ocurrir. Que la idea misma de una “inteligencia artificial” era un timo orquestado para seguir inflando la huida hacia adelante de las tecnológicas, que hace mucho tiempo que no tienen nada real que ofrecer. Bien, pues en las últimas semanas el consenso económico y mediático se ha caído del guindo y está llegando a la misma conclusión.

”Para muchas compañías”, decía hace unos días The Economist, “la emoción por el potencial de la inteligencia artificial generativa ha dado paso a la frustración ante la dificultad de utilizar esta tecnología de manera productiva.”

Por su parte el New York Times, en un artículo titulado “Por qué es improbable que lleguemos a una inteligencia artificial general pronto”, llegaba al fondo del asunto citando a Steven Pinker: “simplemente no existe algo como un solucionador automático, omnisciente y omnipotente de todos los problemas incluidos aquellos que ni siquiera hemos imaginado aún. Existe la tentación de caer en una especie de pensamiento mágico. Pero estos sistemas no son milagros. Son cacharros muy impresionantes.”

La realidad, que es testaruda, se ha impuesto a las amenazas apocalípticas y, según S&P Global, el 42% de las empresas han abandonado en 2025 sus proyectos piloto de IA generativa.

Con todo y con eso, no dejamos de tener la sensación de que esas maquinitas que hablan como si de verdad pensaran tienen que servir para algo. Son demasiado espectaculares para quedarse en nada. ¿No?

Y es que es cierto. Las tecnologías que están detrás de los chatbots van a traer avances muy significativos, solo que no son los que nos han contado.

¿Qué es, de verdad, y para que sirve la IA generativa? ¿Qué podemos esperar que pase con esta tecnología una vez que se pase del todo el hype? ¿Transformará nuestras vidas? ¿Reemplazará a los humanos?

Los humanos evolucionamos para relacionarnos con una comunidad muy pequeña. Hasta la invención de la agricultura, esto es, durante el 95% de la historia de nuestra especie, los grupos humanos tenían entre 25 y 50 miembros. Todo el mundo se conocía íntimamente.

Los antropólogos piensan que, si existía una red extensa que vinculaba unos grupos con otros con los que pudieran coincidir esporádicamente, esa red no podía superar los 150 individuos, porque existe un “límite cognitivo” a la cantidad de relaciones que los humanos somos capaces de mantener sin ayuda de otro soporte.

Los métodos primarios de comprensión del mundo eran la observación directa y el cotilleo. La observación permitía interactuar el entorno inmediato y, como no había ninguna necesidad de comprender lo que estuviera más allá de lo que se podía ver y tocar, con eso era suficiente.

El cotilleo, por su parte, era la mecánica para comprender a los otros humanos. “La cooperación social es nuestra clave para la supervivencia y la reproducción”, dice Yuval Harari, “No basta con que hombres y mujeres conozcan el paradero de los leones y los bisontes, es mucho más importante para ellos saber quién odia a quién en su grupo, quién está enrollado con quién, quién es honesto y quién no es de fiar.”

Cuando pasamos de cazadores-recolectores a los primeros asentamientos agrícolas, se hizo necesario conocer realidades que no podíamos observar directamente. El cotilleo y la observación se volvieron insuficientes y nacieron nuevas tecnologías para comprender y gestionar la complejidad creciente de la sociedad. Por eso la agricultura es inseparable de la aparición de la escritura y de los sistemas numéricos y matemáticos.

Esas dos tecnologías no eran más que una interfaz que nos permitía relacionarnos con una realidad mucho más compleja que la que nuestro cerebro era capaz de manejar por si solo. La escritura nos daba acceso a historias e ideas de personas que no conocíamos y que podían estar muy lejos: en el tiempo y en el espacio. Las matemáticas, por su parte, crearon abstracciones en las que almacenar información sobre grandes grupos, como los registros, la contabilidad o la estadística.

A medida que las sociedades se fueron volviendo más complejas, esas “interfaces” entre la mente humana y la complejidad se fueron perfeccionando: aparecieron los libros, la pintura, la imprenta, los primeros registros de propiedad o de nacimientos, las bibliotecas, las enciclopedias, los ábacos, las calculadoras, las máquinas registradoras, los centros universitarios y administrativos. Todo para dar orden y sentido al mundo.

Llegó un momento en el que éramos capaces de comprender realidades enteras, aunque nunca hubiéramos entrado en contacto directo con ellas: la televisión, la fotografía, la Historia, la literatura, la estadística y los medios de comunicación, entre otras muchas cosas, conseguieron que nos viéramos a nosotros mismos como integrantes de un inmenso grupo social que se expande por siete continentes y que lleva en marcha miles de años.

Los primeros ordenadores nacieron para dar respuesta a esa creciente complejidad. La cantidad de información que usábamos en los años 80 se estaba volviendo ingestionable sin la computación. Los registros en papel, que solo podían “computarse” a mano; sumando y restando, se habían vuelto un cuello de botella para el progreso.

Por eso, la computación produjo un salto exponencial en la capacidad humana para relacionarse con la complejidad. Las máquinas son capaces de almacenar millones de veces más información que un libro y extraen la parte que necesitamos en mucho menos tiempo del que nos llevaría pasar las páginas de una inmensa colección de registros.

Pero, para conseguirlo, tuvieron que hacer una renuncia: esa información ya no estaría ordenada para la comprensión humana —que seguía diseñada para la observación y el cotilleo—, sino para la máquina. Vamos a verlo con un ejemplo:

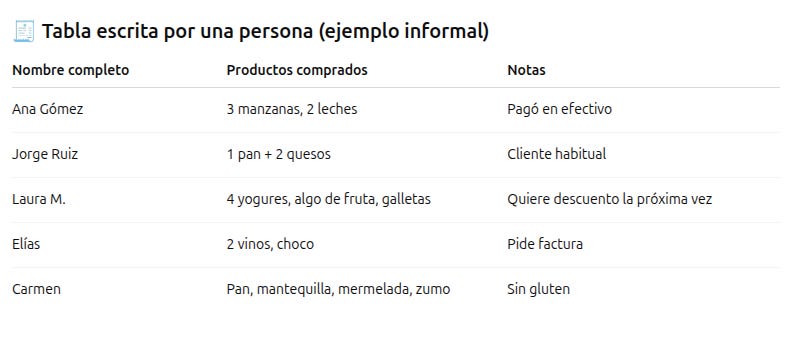

Pensemos en una tienda de alimentos. Este sería el registro que haría una persona de sus ventas, basada en la observación y el conocimiento de cada cliente:

Un ordenador jamás organizaría la información así, mezclando nombres, apellidos, distintos tipos de producto y distintas notas, porque en realidad son cosas muy distintas que solo cobran sentido relacional en nuestra cabeza humana.

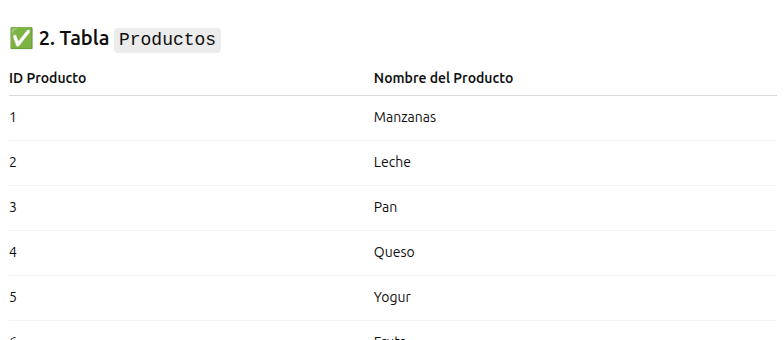

En su lugar, crearía varias tablas:

Una para los clientes,

Otra para los tipos de producto,

Y otra para cada uno de los registros principales donde haría coincidir todas las tablas anteriores con un identificador numérico para cada registro:

El resultado es un sistema mucho más eficiente, mejor organizado, capaz de gestionar mejor la información y de producir informes a demanda… pero incomprensible para la mente humana.

Y entonces llegó Internet. La cantidad de información creada por la humanidad explotó como una supernova. En 1993, toda la web generaba apenas unos 40.000 GB al año; hoy producimos más de 120 zettabytes; 30 millones de veces más. Cada minuto se suben más de 500 horas de video a YouTube, se envían 40 millones de mensajes por WhatsApp y se hacen más de 6 millones de búsquedas en Google. Hemos pasado de almacenar conocimiento en libros y archivos físicos a producir datos masivamente en tiempo real, en una escala nunca antes vista en la historia de la humanidad.

Y todo ese conocimiento no se almacena en un formato adaptado a nuestra mente, sino a las máquinas: es innacesible para los humanos. Por esta razón tenemos esa sensación tan inmensa de no entender nada: porque es verdad, es demasiada información y no disponemos de las interfaces necesarias para procesarla.

Y todo esto ha pasado en un tiempo record: Se estima que más del 90 % de los datos digitales que existen fueron generados en los últimos 10 años y el volumen total de información se DUPLICA cada 12 meses. En campos como la medicina, el conocimiento se duplica cada 73 días.

Como si fuéramos cazadores-recolectores que alguien hubiera teletransportado a la Nueva York de hoy, no tenemos las herramientas para comprender toda esa información, ese nivel de complejidad. Por eso no podemos entender lo que ocurre en las redes sociales y nos abruma la información que recibimos.

La IA como interfaz entre el conocimiento humano y el conocimiento de las máquinas

Los primerísimos intentos de solucionar este problema y darnos una interfaz con la que acceder a este repositorio masivo de conocimiento fueron las búsquedas de Google, primero y los mecanismos tipo “trending topic” y “hashtag” de las redes sociales, después.

Ambos son mecanismos de acceso a la información. Unos te permiten buscar en todo el contenido de Internet y te devuelven unos resultados, y otros te adelantan cuáles son los temas de los que está hablando mucha gente al mismo tiempo. Pero todos tienen la misma limitación, y es que siguen estando diseñados —y limitados— por la mente humana. Siguen queriendo entender desde nuestra forma de pensar un flujo de información que no está ordenado desde esa lógica.

El paso de gigante de la IA es que a alguien se le ocurrió hace unos pocos años que no fueran los humanos los que diseñaran las interfaces para acceder a la información, sino que fueran las propias máquinas.

La idea que está detrás del machine learning y de la IA generativa es el transformer: un tipo de sistema que aprende a entender patrones y relaciones dentro de enormes volúmenes de datos, especialmente en el lenguaje. ¿Cómo aprende? Se le dan millones de preguntas con sus respuestas correctas, y el sistema intenta adivinar la respuesta ajustando una red de conexiones internas llamadas “pesos”. Al principio, falla casi siempre. Pero cada vez que se equivoca, corrige un poco esos pesos. Y así, error tras error, va aprendiendo cómo llegar a la respuesta correcta por su cuenta. Lo sorprendente del transformer es que no sigue un camino fijo: descubre por sí mismo cómo prestar atención a las partes más relevantes de cada frase o conjunto de datos para encontrar sentido.

Así, son las máquinas las que aprenden cómo acceder a la información y cómo mostrarla, sin que tengamos que decirles paso a paso cómo hacerlo. Y la cosa es que lo hacen mucho mejor de lo que nosotros seríamos nunca capaces, porque ese volumen de información está hecho a su medida, no a la nuestra.

La confusión emerge cuando se les da a estos chatbots apariencia de personas con una conciencia: asociamos hablar con ellos a la experiencia de hablar con un experto, caundo lo no son.

Por ejemplo, si le pregunto a un chatbot “qué opinas tú sobre el flequillo muy corto”, me dará una respuesta terriblemente mediocre y llena de lugares comunes. Como no tiene conciencia —ni estilo, ni clase— no puede tener opiniones sobre flequillos, ni sobre nada más.

Cuando le pregunto a un chatbot sobre flequillos, y espero la respuesta de un humano, me da la respuesta estadísticamente más probable: la de un humano medio, esto es, mediocre. Por eso a veces se la inventa, a menudo me aburre, siempre me deja un poco fría.

Pero si, en lugar de pensarlos de esa manera, nos imaginamos que estamos hablando con nuestro ordenador y que queremos usar su inteligencia para acceder al contenido de toda esa información disponible en Internet, se vuelven verdaderamente útiles. Por ejemplo, yo a mi ordenador le preguntaría “Qué se ha opinado en internet en los últimos 5 años sobre el flequillo muy corto”. O “¿Qué opinan en Japón sobre los flequillos?” o ¿Qué opinaban entre 1990 y 2010 sobre los flequillos?”. En este sentido son una versión 2.0 de la que impulsa los buscadores.

Las máquinas no pueden acceder a la verdad, porque la verdad es un concepto que emana de la conciencia. Pero sí pueden abrirnos la puerta a un nuevo nivel del conocimiento humano al que nunca seremos capaces de acceder sin su ayuda.

¿Qué oportunidades traerá este tiempo nuevo?

Photo by julien Tromeur on Unsplash

Muy buen artículo. Me gusta cómo has hilado nuestras limitaciones cognitivas y los avanves tecnológicos. Además, también he tenido un breve momento de morriña con esa introducción a las bases de datos relacionales como viví en la universidad hace algo más de dos décadas.

En la línea de todo esto, te recomiendo el libro "El crecimiento de la información" de Javier Jurado. Ahónda magníficamente en todo ese proceso histórico.

Chapó, la verdad. De todas formas, creo que tenemos un herramienta muy poderosa y que transformará muchos sectores y creará otros nuevos de maneras que aún no podemos imaginar. Cómo la anécdota de las ruedas en las maletas... La rueda ya llevaba unos cuantos de miles de años entre nosotros, pero hasta que a alguien no se le ocurrió unir ese invento con el de una mochila a los demás no nos pareció evidente. Veremos qué otras cosas "evidentes" nos deparan los próximos años y, en mi opinión, los CEO, directivos e inversores no intentan más que adivinar, sin ningún éxito auguro, cuáles serán los próximos inventos para hacer subir unos dólares sus acciones y, por ende, sus nóminas. Muchas gracias por tu artículo. Un saludo ☺️